di Marco Dotti

L’Intelligenza Artificiale (AI) accresce le opportunità. Con le opportunità, moltiplica i rischi. L’impatto sulla vita quotidiana dei sistemi di AI sarà rapido e, senza una sua adeguata comprensione e gestione, non sarà indolore.

Etica, economia, deontologia, responsabilità sociale: ogni aspetto del vivere comune, ogni spazio – pubblico, privato – è già chiamato in causa e, al contempo, messo in discussione dalla grande trasformazione in atto.

Si è aperta dunque una fase nuova per la società civile. Una fase legata all’impressionante sviluppo dei programmi di ricerca applicata legati all’AI, ma soprattutto al ruolo strategico – non solo all’opportunità tattica del loro utilizzo particolare – che questi sistemi avranno negli ambiti per tradizione e storia presidiati dal Terzo Settore: welfare, istruzione, salute e sanità, integrazione, cura, accoglienza, lotta alle disuguaglianze e alle discriminazioni. Lavoro.

Presidiare non basta

In una società come la nostra improntata ai servizi, scenari attendibili ritengono che circa l’80% dei posti di lavoro intellettuale, di fascia medio-alta, verrà sopravanzato dai vantaggi applicativi e competitivi dei sistemi di AI. Altri scenari meno apocalittici prevedono, in luogo della sostituzione, una fase di transizione comunque rapidissimo. In questo secondo scenario sarà la rapidità, più che la fatalità a costituire problema.

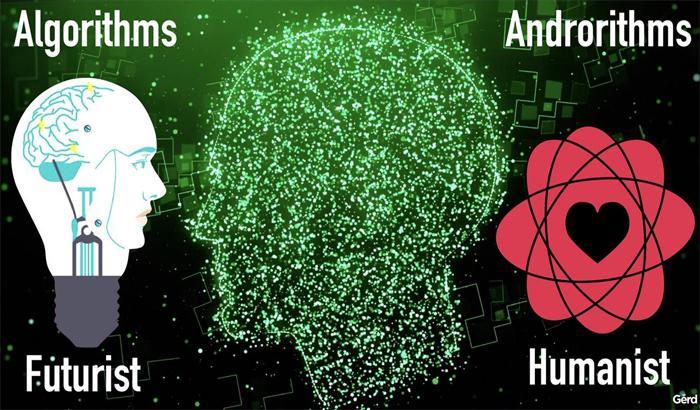

La società civile e, in particolare, il Terzo Settore nelle sue punte avanzate sono chiamati a presidiare tre linee di faglia etica sottraendo il dibattito ai contesti ingegneristici, per declinarlo – in una prospettiva di umanesimo rinnovato e di digital humanities – in forma transdisciplinare.

Presidiare non basta. Occorre dunque pensare un’etica speciale condivisa che permetta, subito, di:

– contrastare gli usi malevoli dell’AI , fake news, machine bias, profiling, trasformazione del cittadino e del consumatore in targets, ingegnerizzazione delle abitudini, costruzione di addictions, etc.);

– contenere, anche in assenza di un’intenzione malevola, l’impatto socio-economico e lavorativo fortemente diseconomico dell’AI, riducendo i costi e ripartendo su base sociale i vantaggi;

– ridurre la black box, la camera oscura che a oggi, dietro lo schermo della proprietà commerciale, impedisce il controllo effettivo degli algoritmi di base dell’AI;

– incrementare la responsabilità sociale attraverso l’approccio human-in-command: le macchine devono costantemente restare sotto controllo umano e il processo innescato, per essere innescato, deve poter essere fermato in ogni momento;

– garantire un sistema open data che garantisca l’accesso condiviso a enti di ricerca, non solo la tutela individuale, ai dati sensibili utilizzabili per finalità comuni.

L’uomo al centro

Al contempo occorre ripensare a un’etica che abbia l’umano al centro e non alla periferia – in cui rischia di essere confinato – del sistema.

Sul piano dell’etica generale occorre richiamare alla responsabilità di ogni visione:

– se l’AI sarà for good or not for good dipende in gran parte dalla visione dell’uomo di cui programmatori (designers), utenti, governo e società civile si stanno facendo portatori. Ma da questa visione non dipenderà solo l’orientamento di un particolare ambito applicativo tecnologico. Per la potenza dispiegata dai sistemi di AI, ne discenderà una posizione di subalternità complessiva o di rinnovata centralità dell’umano. La scelta è di campo e da questa scelta dipenderanno le forme future del convivere e del confliggere.

Sul piano dell’etica particolare occorre pensare concretamente a:

– Etica per i designers (responsible design): definire un design etico che nell’attività di progettazione e programmazione non si orientisul cosiddetto machine bias, incrementando pregiudizi su base predittiva, favorendo la manipolazione di attenzione, credenze, modelli cognitivi.

– Etica per gli utenti: orientare a un uso concretamente responsabile dell’AI imprese, governi, centri di ricerca, utenti ordinari;

– Etica nellapolitics e nella policy: definire gli ambiti invalicabili per i quali non è ammessa alcuna delega all’AI nelle scelte concrete (es: licenziamenti; selezione del personale).

Oltre il disimpegno morale

Dobbiamo impedire che il software design inneschi un processo irreversibile di deleghe in bianco su interventi che vertono sulla sussistenza stessa della vita umana (quando interrompere una terapia, quando intervenire, valutazione di rischi-benefici non fondata unicamente su prospettive utilitaristiche, etc.), non meno che su valori, relazioni, visioni che sono alla base del legame civile. Questo fenomeno produrrebbero effetti di moral disengagement con effetti domino di matrice sistemica.

La società civile e il Terzo Settore avanzato sono chiamati a rappresentare l’avanguardia nel tracciare il nuovo scenario in cui l’AI venga fin da ora ripensata by design, come una forma per ottimizzare risorse e massimizzare benessere condiviso.

Dovremmo ripensara a un’etica della volontà adattandola a nuove sfide. Un’etica dei valori che ribadisca la centralità umana dinanzi a sfide che rischiano prescindere da questa centralità.

In questo senso, propongo qui di seguito 10 punti come call for action e, al contempo, come terreno comune su cui generare riflessione e approfondimento. L’invito è rivolto a soggetti, individuali e collettivi, che condividano di contro ai facili entusiasmi le criticità che abbiamo elencato e abbiano a cuore il destino e la vita stessa di un legame sociale che potrebbe essere vivificato, ma non per questo meno scosso dall’AI alle sue radici. La tecnica non è buona o cattiva a seconda dell’uso che se ne fa (anche questo, ovviamente).

La tecnica è soprattutto un contesto. Un design. Proprio per questo ogni tecnica porta in sé una precisa riconfigurazione del legame sociale. Renderla esplicita e, al contempo, affrontarla è – in tutta umiltà – un compito a cui il Terzo settore avanzato non può sottrarsi.

Un manifesto per l’etica dell’AI

1. Gli sviluppatori di software, algoritmi, AI sono chiamati a definire, chiarire, dichiarare senza ambiguità la propria visione dell’uomo e la sua centralità rispetto alla “macchina”.

2. Sviluppatori di software, algoritmi, AI sono chiamati a interessarsi alle implicazioni etico-morali derivanti dal loro uso o abuso, tenendo conto in fase di programmazione e progettazioni di queste possibilità.

3. Tutti i sistemi di AI devono essere progettati e condotti a operare in maniera compatibile con i valori della dignità, del rispetto e della libertà umana.

4. I sistemi di AI dovrebbero essere progettati in modo tale che i loro obiettivi e comportamenti si allineino con i valori umani di dignità, libertà e rispetto durante tutto il loro funzionamento.

5. I sistemi di AI devono orientarsi alla massima condivisione di conoscenza, benefici e empowermentdel maggior numero di persone possibile.

6. Il tema della redistribuzione del lavoro deve essere da subito al centro dell’azione del Terzo Settore.

7. Istituzioni pubbliche, imprese for e non profit, consapevoli dell’inevitabile ricaduta collettiva delle loro scelte di campo su AI, Big Data e algoritmi, sono chiamati a dotarsi di criteri di controllo umano preventivo e permanente sugli effetti delle loro scelte.

8. Imprese for e non profit si impegnano fin da ora a adottare, e il legislatore si impegna a introdurre ex lege, ambiti che non possono essere delegati alle scelte autonome e deresponsabilizzanti dell’AI, quando queste scelte impattano sui fondamenti della vita umana (sospendere le cure a un malato; licenziare o assumere una persona, etc).

9. Il potere decisionale, pubblico e privato, conferito a sistemi di IA altamente avanzati anche nell’ambito del Terzo settore dovrebbe rispettare e migliorare, piuttosto che sovvertire, i processi sociali e civici da cui dipende la salute della società. Nel contesto sanitario va tutelata la qualità della relazione umana che non può, né deve, in alcun modo essere sostituita o trovare supplenza in dispositivi algoritmici o di AI mediati da schermi o robot.

10. Istituzioni e soggettività for e non profit si devono dotare di una figura interna di controllo (ethical manager) e di un’autorità esterna di vigilanza che vigili sul loro utilizzo e sulle scelte delegate ai sistemi di AI.

Link articolo: Un’etica umana per l’intelligenza artificiale